Трансформация маскулинности в рэпе: доработка и детали. Дискуссия

Участники научного коллектива и гости задали Антону Бойченко много вопросов

- Старая и новая школы в рэпе. Как это учесть?

- Про предобработку: зачем остались апострофы?

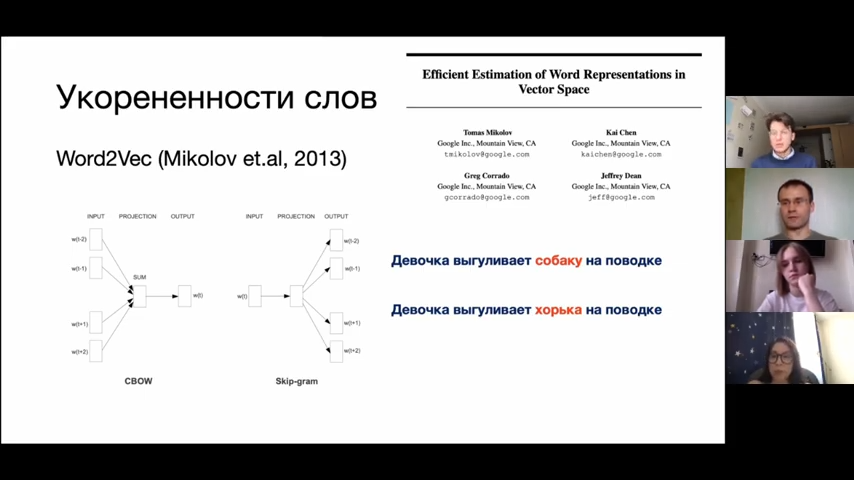

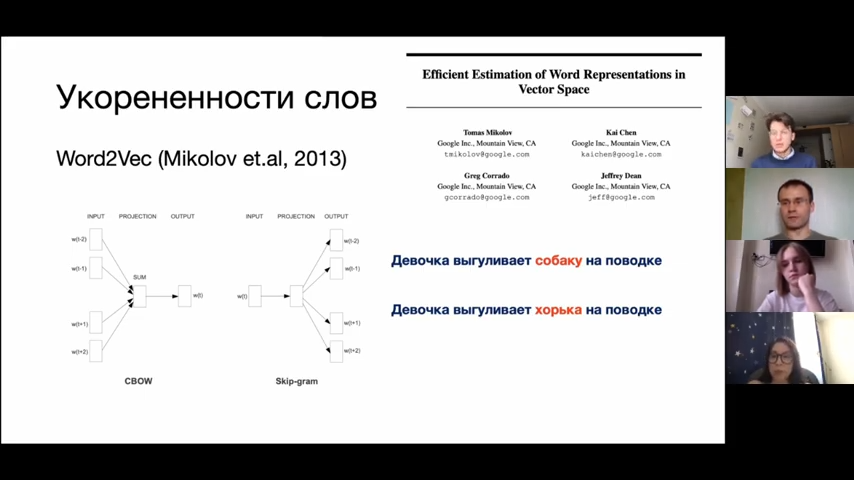

- Как соотносятся BigARTM и Word2Vec?

- Почему Word2Vec, а не BERT?

- Как выглядят векторы близкие по контексту слова?

- Как происходило разделение на временнЫе периоды?

- Word2Vec – машинное обучение БЕЗ учителя, а BERT – машинное обучение С учителем. Как из сравнивать?

- Word2Vec порождает для каждого слова один вектор, а BERT – может несколько.

- Контекстуальность Word2Vec и BERT.

- Центральные слова.

- Близость слов и мешок слов (CBOW).

- Динамика топиков в рэпе происходит из-за прихода авторов из ненегритянских слоёв или из-за улучшения положения негритянских слоёв

Особенно оживлённая дискуссия развернуась вокруг соотнесения алгоритмов Word2Vec и BERT.

Приглашаем Вас наблюдать за работой научного коллектива на нашем YouTube-канале. И не только наблюдать, но и присоединяться.